No se fíen de Google

Aunque, según las encuestas, la mayoría de la gente cree que los buscadores que casi constantemente utilizamos en la red son imparciales, lo cierto es que generan un sesgo muy importante en nuestra percepción del mundo y una influencia unilateral decisiva en nuestras decisiones y actuaciones.

Las webs empresariales utilizan “cookies” y otros procedimientos sofisticados que se instalan en nuestros ordenadores apenas lo consintamos, bien sea deliberadamente o por descuido. Así detectan nuestras búsquedas y a partir de ellas puedan ofrecernos productos comerciales que se adecúen a nuestras aficiones o demandas. En su interesante libro El filtro burbuja: cómo la web decide lo que leemos y lo que pensamos, Eli Parisier explica que, al escribir la palabra “depresión” en un diccionario on line, la web instalará 223 cookies y dispositivos de rastreo para que otras web puedan ofrecer a quien la haya escrito productos antidepresivos: “comparte un artículo de cocina de ABC News -dice en otro lugar del libro- y puede que te acaben persiguiendo por internet anuncios de ollas antiadherentes. Abre -aunque sea por un instante- una página en la que se enumeren signos de que tu mujer puede estar engañándote y prepárate para que te persigan anuncios de pruebas de paternidad”.

Se trata de un procedimiento legal pero que puede dejar de serlo cuando se aplica manipulando los algoritmos que proporcionan las respuestas del buscador, como ha ocurrido con Google. La Comisión Europea multó en junio pasado a este gigante de la red con 2.420 millones de euros por manipular los resultados de búsqueda con el fin de dirigir a los usuarios, de forma inapropiada y en perjuicio de sus competidores, a su propio servicio de compras, Google Shopping.

Pero los buscadores no solo se conciben o incluso se manipulan con fines meramente comerciales sino que también están diseñados para incidir estratégicamente en nuestra percepción del mundo y, por tanto, en los criterios de los que dependen nuestras decisiones personales y políticas. La información que nos proporcionan no es ni mucho menos neutra u objetiva, como generalmente se cree, sino que nos llega previamente filtrada en función del perfil específico que de cada uno de nosotros haya compuesto el algoritmo correspondiente. “La consulta ‘células madre’ -sigue diciendo Parisier en su libro- puede producir resultados diametralmente opuestos en el caso de que los usuarios sean científicos que apoyan la investigación o activistas que se opongan. ‘Pruebas del cambio climático’ puede deparar resultados diferentes a un activista medioambiental y a un directivo de una compañía petrolífera”. Así es como los buscadores introducen un sesgo constante que, sin que seamos conscientes, nos impide disponer de una visión plural de los fenómenos sobre los que, a través de ellos, indagamos en la red. Sin que podamos ser conscientes de ello, van conformando nuestra percepción del mundo.

Y ni siquiera eso es lo peor. Los buscadores no solamente filtran la información disponible para hacernos llegar preferentemente la que previamente parece más adecuada a nuestro perfil predefinido. Además de ello, seleccionan las fuentes de la información y eliminan las que pueden considerarse más indeseables o molestas, por decirlo de alguna manera, para el “saber establecido”. Y, paradójicamente, la excusa que se utiliza para homogeneizar la información y para silenciar la información alternativa es que hay que evitar que se difunda la falsedad y garantizar que en la red se divulgue la verdad. Paradójica, porque el resultado de esa aparentemente noble pretensión es que se fortalecen visiones del mundo que no son precisamente las que mejor reflejan la realidad.

El caso de Google es singularmente significativo. En mayo pasado anunció una actualización de sus directrices para “evaluar la calidad de búsqueda” con el fin de “proporcionar ejemplos más detallados de páginas web de baja calidad para que los evaluadores marquen adecuadamente”. Unos evaluadores que son los que supuestamente tienen como función rechazar las noticias falsas, los “fakes”, las “experiencias molestas para el usuario” y las “teorías de conspiración”, hoy día tan abundantes como perniciosas.

Hace un año, la agencia Reuters publicó un artículo informando del nacimiento de una organización sin fines de lucro que iba a trabajar para fomentar y garantizar la confianza y la verdad en la era digital combatiendo la difusión de noticias falsas. Se llamaba First Draft Coalition y en ella estarían incluidas grandes corporaciones de la información como Google, Facebook, Twitter, The New York Times, The Washington Post, BuzzFeed News, Agence France-Presse o CNN. Meses más tarde, en mayo pasado, Google seguía esa línea y anunció una actualización de sus directrices para “evaluar la calidad de búsqueda” con el fin de “proporcionar ejemplos más detallados de páginas web de baja calidad para que los evaluadores marquen adecuadamente”. Unos evaluadores que son los que supuestamente tienen como función rechazar las noticias falsas, los “fakes”, las “experiencias molestas para el usuario” y las “teorías de conspiración” hoy día tan abundantes como perniciosas.

Cualquier persona sensata consideraría que el objetivo de Google es bienintencionado, sobre todo, cuando eso se hacía con las miras puestas en evitar el cúmulo de manipulaciones y mentiras de todo tipo que circularon en la red durante las últimas elecciones estadounidenses (aunque habría que decir que no solo entonces, porque la red también fue una fuente de influencia estratégica no explicitada en la elección de Obama).

Sin embargo, lo cierto es que ese cambio de criterios de Google se ha traducido en un nuevo algoritmo de búsqueda con resultados muy significativos: las webs progresistas han resultado silenciadas en los resultados que el buscador proporciona en materias económicas, políticas y sociales de especial trascendencia, produciendo así una disminución sorprendente en el número de personas que las visitan.

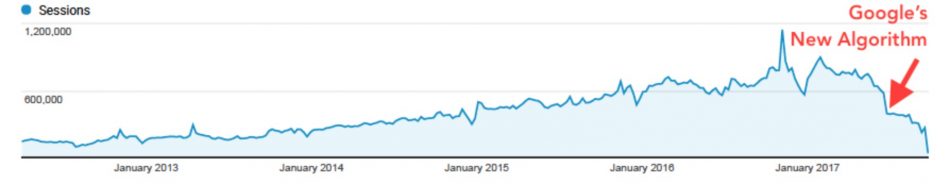

El portal World Socialist Web Site ha analizado los datos estadísticos que proporciona SEMrush sobre el tráfico en la red desde junio (cuando comenzaron a aplicarse las nuevas directrices de Google) a septiembre de 2017, y los resultados son bien evidentes: wsws.org cayó el 67%, alternet.org el 63%, globalresearch.ca el 62%, consortiumnews.com el 47%, socialistworker.org el 47%, mediamatters.org el 42%, commondreams.org el 37%, internationalviewpoint.org el 36%, democracynow.org el 36%, wikileaks.org el 30%, truth-out.org el 25%, counterpunch.org el 21% y theintercept.com el 19%. La gráfica siguiente que proporciona alternet.org con la evolución de visitas a su web habla por sí sola (su editorial sobre el tema aquí).

Hasta un medio tan convencional y vinculado al establishment como The New York Times se hizo eco de los efectos del cambio de directrices de Google sobre las webs alternativas (As Google Fights Fake News, Voices on the Margins Raise Alarm) y muchos analistas están tratando de discernir el cambio efectivo que han supuesto las nuevas directrices sobre el uso estratégico de la información en la red.

La pregunta que se hace cualquiera que sepa que las páginas alternativas y de izquierdas son las que resultan silenciadas por estos nuevos criterios es si realmente estas son las webs que principalmente difunden falsedades.

Y lo bueno es que sabemos a ciencia cierta que eso no es así.

El profesor de la Universidad de Elon en Carolina del Norte (Estados Unidos) Jonathan Albright analizó los sitios en donde 306 web de derechas difundieron falsedades y encontró que habían ido a 23.000 páginas a través de 1,3 millones de hipervínculos (The #Election2016 Micro-Propaganda Machine). Mapeó los resultados y le salió la imagen de más abajo en la que se distingue claramente que los mayores difusores de mentiras de derechas a nivel mundial son, precisamente, las grandes corporaciones mediáticas que dicen combatir la difusión de falsedades… silenciando para ello a las páginas web progresistas y de izquierdas.

Pinchar en la imagen para ampliar

Pero Albright descubrió algo más. Las grandes corporaciones mediáticas no solo difunden una mentira para que circule lo más ampliamente posible por la red sino que eso se hace de modo que se pueda adoctrinar con la mayor eficacia: “Vi los trackers en esas páginas y me quedé asombrado. Cada vez que alguien da un like a una entrada de Facebook o visita una de esas páginas, los scripts te siguen por toda la web. Y esto permite a empresas de recolección de datos y de influencia, como Cambridge Analytica, identificar con precisión a individuos, a seguirlos por la web y enviarles mensajes políticos muy personalizados. Es una máquina propagandística. Identifica individuos para convencerles de una idea. Es un nivel de ingeniería social que nunca había visto antes. Estás atrapando a la gente y luego les mantienen atados a una correa emocional y nunca les sueltan” (Google, la democracia y la verdad sobre las búsquedas en internet).

El asunto es serio y conviene ponerse a resguardo. Quien desee disponer de información mínimamente plural y exenta de manipulación no se puede fiar de los grandes buscadores y más concretamente de Google, una especie de Gran Hermano Buscador que ejerce un monopolio de facto sobre el que nadie termina de pronunciarse. Pero, ojo, tampoco de las web de los grandes portales, como Facebook, que aparentemente solo nos ofrecen conectividad y entretenimiento; ni de los grandes medios que son los que en la práctica propagan las mentiras que dicen combatir.

Hay buscadores y fuentes alternativas. No son tan potentes como Google pero permiten sortear las limitaciones de éste último y, sobre todo, sus estrategias profundas y no bien confesadas. Y existen también medios digitales e impresos que ofrecen otra información menos sesgada y más libre que los más conocidos y poderosos, propiedad de las grandes corporaciones. Ya saben que no se puede ser libre sin estar bien informado, así que no se fíen y elijan bien.

Fuente: http://www.juantorreslopez.com/no-se-fien-de-google/