Las mentiras visuales de la IA

A medida que se expande la inteligencia artificial en cada rincón de nuestras vidas, un cliché se consolida: el de representar visualmente estos sistemas como robots humanoides blancos, cerebros destellantes o con referencias a la ciencia ficción. Un grupo cada vez mayor de especialistas se opone a esta iconografía cargada de sesgos históricos sobre género, etnia y religión que genera expectativas poco realistas y enmascara los efectos sociales de estas tecnologías.

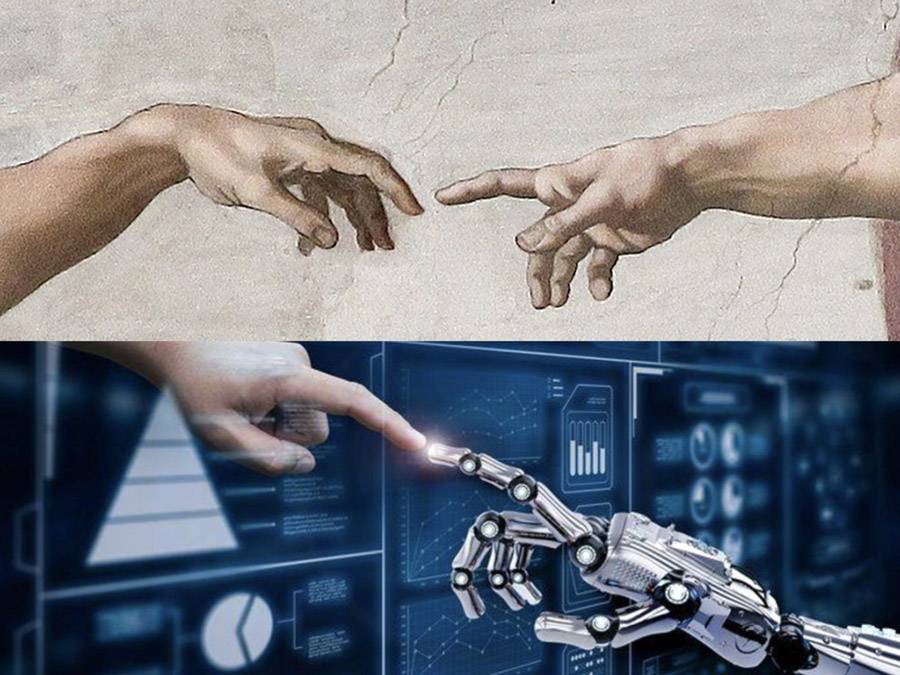

El 25 de abril de 2018, la Comisión Europea publicó un documento que marcó el inicio de su camino hacia la primera ley regulatoria de la inteligencia artificial del mundo. En él, se detallaban las recomendaciones presentadas por un grupo de expertos, se enumeraban los pasos a seguir y se proponían directrices éticas para una IA confiable. Sin llamar mucho la atención, una atractiva imagen acompañaba al texto: una mano humana y una mano robótica –brillante y metálica– se extendían delante de un fondo azul y gris, casi tocándose con las yemas de los dedos.

Inspirada en La creación de Adán de Miguel Ángel, fresco que desde el siglo XVI adorna el techo de la Capilla Sixtina en el Vaticano, esta composición que presenta a la IA como una fuerza creativa divina o como una chispa, una conexión entre lo humano y lo divino, se ha convertido en uno de los pósteres oficiales de la inteligencia artificial.

Se la ve una y otra vez en sitios de noticias y revistas, en publicidades, en portadas de libros, en comunicados de empresas, en afiches de cursos y conferencias, a la par de retratos pintorescos de robots humanoides siempre blancos, cerebros azules brillantes, placas de circuitos, código binario y trilladas referencias a personajes de ciencia ficción como Terminator.

Conforman la iconografía actual de la IA, su traducción visual, cada vez más criticada por especialistas que advierten sobre sus peligros y las suposiciones estereotipadas y potencialmente discriminatorias que arrastran sobre género, etnia y religión.

“Estas imágenes tergiversan completamente las realidades de la IA”, advierte a SINC la investigadora en ética Tania Duarte, fundadora de We and AI, una organización sin fines de lucro del Reino Unido que busca mejorar la alfabetización en inteligencia artificial para la inclusión social e impulsar el pensamiento crítico. “Refuerzan mitos sobre la IA –subraya–, ideas falsas sobre la infalibilidad, la sensibilidad y el misticismo religioso que envuelve a estas tecnologías y no ayudan al público a desarrollar una comprensión de lo que está en juego”.

El poder de la imagen

Como hace tiempo explicó la escritora Susan Sontag, las imágenes son elementos poderosos. Enmarcan nuestra percepción del mundo, confirman, refuerzan o disipan estereotipos. Influyen en la forma en que la sociedad piensa y comprende temas que retratan. En el caso de la IA, ciertas ilustraciones exageran las capacidades de estos sistemas informáticos cada vez más ubicuos.

Otras, en cambio, siembran miedo, aumentan la desconfianza pública, enmascaran la responsabilidad de los humanos y perpetúan un entendimiento demasiado limitado y temeroso de la IA pero también misterioso, al no mostrar su contexto real, ni sus procesos y ni sus aplicaciones o limitaciones. Y desvían el debate sobre las consecuencias potencialmente significativas para la investigación, la financiación, la regulación y la recepción de estos sistemas cada vez más ubicuos.

Con el apoyo del Alan Turing Institute, el Centro Leverhulme para el Futuro de la Inteligencia y del departamento de investigación y desarrollo de la BBC, exponen cómo estas representaciones dominantes refuerzan conceptos erróneos y limitan la comprensión pública del uso y funcionamiento de los sistemas de IA.

“Necesitamos imágenes que retraten de manera más realista la tecnología y las personas detrás de ella y que señalen sus fortalezas, debilidades, contextos y aplicaciones”, indican sus promotores, que ofrecen un repositorio gratuito de mejores imágenes de IA y una guía de consejos para un uso responsable.

Fábricas de imágenes

Una parte importante de las fotografías e ilustraciones que se emplean en publicidades, marketing corporativo, diseño de sitios web y también en sitios de noticias provienen de “fábricas de imágenes”: el negocio de las fotografías de archivo o de stock, una industria global de miles de millones de dólares, dominada por un puñado de corporaciones transnacionales –Getty Images, Corbis, Alamy, Shutterstock, Adobe Stock, Science Photo Library (SPL), entre otras–, con una fuerza poderosa en la cultura visual contemporánea.

Como indican los investigadores Gaudenz Urs Metzger y Tina Braun de la Escuela Superior de las Artes de Zúrich (Suiza) en un estudio publicado en el Journal of Death and Dying, estas imágenes influyen en cómo se imagina un tema, así como en lo que se puede decir y no decir en una sociedad.

A medida que las empresas periodísticas invierten cada vez menos en fotógrafos y diseñadores de infografías, las imágenes de stock expanden su presencia.

Por lo general, se trata de montajes, gráficos o ilustraciones genéricas, con un estilo realista, aunque más simbólico que documental, que buscan atraer la atención del lector al representar visualmente temas complejos como las tijeras moleculares de la técnica CRISPR de edición genética, el mundo subatómico, el interior del cuerpo humano, la computación cuántica, el blockchain (cadena de bloques) o la computación en la nube.

En el caso de la IA, el robot humanoide blanco ha sido elevado en el último tiempo al rol de embajador visual de estas tecnologías complejas por directa influencia de la cultura popular. Como registró el AI Narratives Project de la Royal Society de Londres, existe una fuerte tendencia a concebir las máquinas inteligentes con forma humana.

Una IA con formas hipersexualizadas

“Cuando las personas imaginan a otros seres inteligentes, estas imaginaciones tienden a tomar forma humanoide”, destaca el documento principal de esta iniciativa. “Una consecuencia de este antropomorfismo es que los sistemas de IA son con frecuencia representados con género: sus formas físicas a menudo no son andróginas, sino que tienen las características sexuales secundarias estereotipadas de hombres o mujeres. De hecho, a menudo están hipersexualizados: tienen cuerpos masculinos exageradamente musculosos y tendencias agresivas, como Terminator, o formas femeninas convencionalmente hermosas como Ava en la película Ex Machina”.

La IA y sus ramas, como el aprendizaje automático, no son temas sencillos de explicar ni de ilustrar. Pero imaginar estas tecnologías como androides es problemático: desinforma, plantea expectativas demasiado altas, sugiere que su fin último es el de reemplazar a los humanos y dificulta que se consideren sus beneficios reales. Además, cuanto más humanos se ven estas representaciones, más étnicamente blancas son sus características.

De ahí que Stephen Cave y Kanta Dihal, investigadores de la Universidad de Cambridge (Reino Unido), señalen en su ensayo The Whiteness of AI que la representación de la IA sufre de un problema racial. “Imaginar máquinas que sean inteligentes, profesionales o poderosas es imaginar máquinas blancas porque el marco racial blanco atribuye estos atributos predominantemente a la blancura”, dicen los también autores de Imagining AI: How the World Sees Intelligent Machines.

“En las sociedades europeas y norteamericanas, la blancura está normalizada hasta tal punto que la vuelve en gran medida invisible. Al centrar la blancura como el color predeterminado del futuro, estas imágenes contribuyen a imaginar un futuro tecnológico que excluye a las personas de color de la misma manera que lo hacen las grandes empresas tecnológicas en la actualidad”, apuntan.

Clichés y confusión sobre la IA

Los clichés visuales son varios: placas de circuitos, código binario descendente, brillantes cerebros situados en un espacio oscuro y vacío, aislados de las necesidades de un cuerpo, es decir, una clara alusión a la inteligencia, si bien gran parte de la IA y el aprendizaje automático que se utilizan hoy en día están muy alejados de la inteligencia humana. “Las personas que no entienden qué es la IA no pueden defender las formas en que la tecnología debería o no impactar a la sociedad”, señala Duarte.

Además de la prevalencia de robots blancos, el color favorito de las empresas de tecnología para representar sus sistemas es el azul, usualmente asociado con inteligencia, confianza, seriedad, eficiencia pero también con masculinidad, como destaca la historiadora Alexandra Grieser en Blue Brains: Aesthetic Ideologies and the Formation of Knowledge Between Religion and Science.

“Existe una gran brecha entre la realidad de la IA y la percepción que tiene el público general, que es alimentada por representaciones en los medios y películas que a menudo presentan la IA como robots autónomos con capacidades casi humanas”, indica la desarrolladora de software mexicana Yadira Sánchez, asesora de Better Images of AI.

“Esta distorsión es preocupante porque impide que el público comprenda y participe efectivamente en debates cruciales sobre cómo la IA está remodelando áreas esenciales como la atención médica, la agricultura y la vigilancia estatal. Además –añade–, estas imágenes inexactas crean pensamientos futuristas muy optimistas o muy pesimistas sobre la IA y esto es peligroso porque generan expectativas y miedos en la sociedad”.

Otras imágenes para minimizar la confusión

Para minimizar la confusión, sostienen los investigadores de Better Images of AI, es importante utilizar imágenes que representen honestamente la realidad de la IA, como los recursos naturales y materiales que se consumen en su desarrollo. Por ejemplo, la extracción de litio en América Latina, o el agua y los ríos que se usan para mantener centros de datos en funcionamiento.

“Deberíamos mostrar cómo la IA se integra y afecta nuestros entornos naturales y sociales”, agrega Sánchez, “y cómo su infraestructura impacta directamente en el ecosistema y la vida cotidiana de las personas”.

“La enfermedad de la fotografía de stock de la IA ha alcanzado el estado epidémico”, señaló hace unos años el investigador Adam Geitgey, especialista en aprendizaje automático y reconocimiento facial. Aunque la IA no es la única rama científica que sufre estas tergiversaciones visuales. Más bien, todas las disciplinas, en algún grado u otro, las padecen cuando son representadas en periódicos, avisos publicitarios, campañas públicas o en webs de instituciones.

“Los medios optan por la solución más sencilla: utilizar imágenes que la gente reconozca y asocie rápidamente con la ciencia”, apunta la socióloga portuguesa Ana Delicado, quien estudió las representaciones visuales de la ciencia durante la pandemia de la covid-19 en sitios web de instituciones políticas y medios de comunicación en Portugal y España.

“Las imágenes de stock siempre se basan en estereotipos. Son productos comerciales: su objetivo es vender, no reflexionar sobre los temas que venden. Las imágenes estereotipadas en los medios de comunicación contribuyen a perpetuar representaciones estereotipadas en la opinión pública”, recalca.

En su análisis, publicado en la revista Frontiers in Communication, esta investigadora del Instituto de Ciencias Sociales da Universidad de Lisboa registró el abuso de ilustraciones del coronavirus SARS-CoV-2 con sus púas y pintado de rojo, haciéndolo parecer más amenazador.

También detectó una gran lista de elementos visuales que aluden a la actividad científica: hélices de ADN, células, moléculas, radiografías, equipos de laboratorio como microscopios, tubos, placas de Petri y pipetas, a menudo sostenidos por manos incorpóreas enguantadas, así como la presencia de personas con batas blancas, gafas protectoras y mascarillas, pero sin diversidad étnica, lo que refleja la subrepresentación de las minorías en la comunidad científica.

“La elección de imágenes para ilustrar la ciencia de la covid-19 tiende a reproducir nociones estereotipadas de la investigación científica como una actividad centrada en el laboratorio”, indica Delicado.

Nuevos generadores del imágenes

Ahora, con el auge de los sistemas de IA generadores de imágenes, como Stable Diffusion, Midjourney y DALL·E, se teme que empeoren las distorsiones sobre la realidad de la IA y la actividad científica en general. Como ya han demostrado algunas investigaciones, estas herramientas que producen imágenes a partir de indicaciones de texto suelen dar resultados racistas y sexistas.

Es decir, reproducen y amplifican sesgos raciales y de género, pues son entrenadas con imágenes utilizadas por medios de comunicación, organizaciones mundiales de salud y bases de datos de internet. “Estas imágenes son utilizadas sin crítica, sin reflexión”, advierte la socióloga portuguesa, “y la IA va a seguir perpetuando los estereotipos sobre la ciencia y las tecnologías”.

Fuente: SINC